| O "Crescimento" da Computação (Unidade 1) |

|

|

| Escrito por Administrator | ||||||

| Sex, 26 de Agosto de 2011 04:33 | ||||||

|

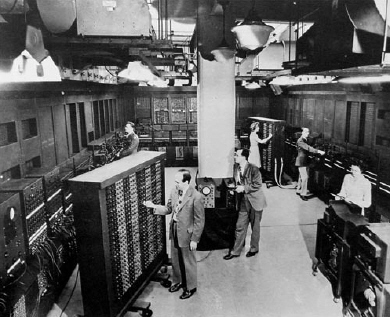

Desde meados de 1600, com o surgimento das primeiras máquinas de calcular, até os dias atuais, o homem, em uma luta incansável, tem procurado otimizar seus mecanismos computacionais na medida que tais otimizações possam a caber no seu bolso(ou, em alguns casos, possam beneficiar o seu bolso ;)) As primeiras maquinas de grande porte(não cabe aqui mencionar as maquinas de Pascal, Babbage e semelhantes) surgiram por volta dos anos 40, pesavam algumas toneladas e eram repletas de válvulas. A mais famosa dessas maquinas, o ENIAC, por exemplo, possuía certa de 17 mil válvulas a vácuo, as quais necessitavam de grande mão de obra apenas para mantê-las funcionando. Não demorou muito para o homem perceber o grande desperdício(consumo de energia, espaço e etc) e investir mais nos famosos transistores e nos diodos semicondutores. Tais esforços permitiram a compactação dos transistores em módulos menores, que foram chamados de Circuitos Integrados. Com dinheiro disponível, ambição e conhecimento acumulado, logo os Circuitos Integrados passaram a “integrar” mais transistores e, então, evoluíram para os chamados Chips.

De lá para cá, o homem continua a brincar com essa arquitetura. Hora produz um processador com um conjunto específico de operações, hora produz um genérico e utiliza interpretação(em software) para instruções complexas. Ainda outrora usa uma combinação de ambos os modelos(é, isso mesmo, segundo Tanenbaum o Pentium em diante realiza operações simples em RISC e as demais em CISC). O próximo passo foi usar paralelização com pipeline, mas ainda não era suficiente. O dinheiro ficou mais acessível, então o homem adicionou o multiprocessamento na arquitetura, com cores totalmente independentes, compartilhando a mesma memória. A quantidade de cores nos multiprocessadores cresceu mais do que o dinheiro podia bancar, então foi hora de mudar o paradigma mais uma vez e criar os multicomputadores. Com eles, a limitação na quantidade de cores deixou de existir e cada um tem a sua própria memória privada. Estes últimos ganham mais memória cache(com o baratear destas), expandem com novos núcleos de processamento gráfico e, assim, continuam a “engordar”, dia após dia. Até mesmo os softwares precisaram "engordar", haja vista o modelo de programação mais complexo exigido pelos multicomputadores (ora, mas a tendencia não deveria ser simplificar e abstrair a complexidade dos softwares?) Com os problemas cada vez mais complexos, softwares cada vez menos preocupados com as limitações de hardwa re, o conhecimento e investimentos financeiros mais acessíveis, será que a maquina do futuro irá crescer tanto quanto o ENIAC? Ou “voltará” a encolher?

Somente usuários registrados podem escrever comentários!

!joomlacomment 4.0 Copyright (C) 2009 Compojoom.com . All rights reserved."

|

||||||

| LAST_UPDATED2 |

Haja vista a necessidade de melhor utilizar esse “poder” de calcular, um cara(nerd) chamado Von Neumann surgiu na história dessas maquinas e, com uma simples(hoje é fácil =)) e brilhante ideia, definiu a Arquitetura dos Computadores que utilizamos até os dias atuais. Em suma, a Arquitetura de Neumann prevê, além do processador, e sua respectiva Unidade de Controle, uma memória principal que armazena os dados de um programa e suas próprias instruções(bingo!), possibilitando que ocorram desvios na execução. A Unidade de Controle obtém, então, os dados e a respectiva operação que deverá executar sobre estes. Naturalmente existem outros elementos, como os barramentos de dados, de endereço, de controle, acumulador, registrador de dados, registrador de endereço, contador(ou ponteiro) de endereço e etc, mas tais mecanismos são “apenas” a forma de se implementar o principal, a ideia!

Haja vista a necessidade de melhor utilizar esse “poder” de calcular, um cara(nerd) chamado Von Neumann surgiu na história dessas maquinas e, com uma simples(hoje é fácil =)) e brilhante ideia, definiu a Arquitetura dos Computadores que utilizamos até os dias atuais. Em suma, a Arquitetura de Neumann prevê, além do processador, e sua respectiva Unidade de Controle, uma memória principal que armazena os dados de um programa e suas próprias instruções(bingo!), possibilitando que ocorram desvios na execução. A Unidade de Controle obtém, então, os dados e a respectiva operação que deverá executar sobre estes. Naturalmente existem outros elementos, como os barramentos de dados, de endereço, de controle, acumulador, registrador de dados, registrador de endereço, contador(ou ponteiro) de endereço e etc, mas tais mecanismos são “apenas” a forma de se implementar o principal, a ideia!